O deep learning (DL), em tradução livre “aprendizado profundo”, está inserido dentro da inteligência artificial (IA) e vem contribuindo muito para a ciência atualmente. O DL usa redes neurais profundas que tem o objetivo de imitar neurônios humanos, usando cálculos matemáticos.

Existem alguns tipos de redes neurais, que têm sido aprimoradas com o passar do tempo, as quais abordam este texto. São elas: as redes neurais convolucionais (CNN, convolutional neural networks), redes neurais recorrentes (RNN, recurrent neural networks) e as memória longa de curto prazo (LSTM, long short-term memory cells) que fazem parte das RNN.

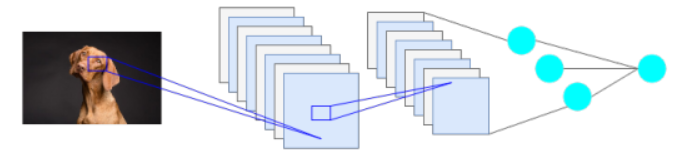

As CNN são um tipo de rede neural usada para a identificação de imagens, agrupando-as ou fazendo reconhecimento, para problemas biológicos essas redes podem ser usadas para localizar sequências também. São redes capazes de captar imagens e atribuir pesos que vão passando para todas as camadas de convolução, esses pesos avaliam pequenas partes das imagens com diferentes filtros que tem o objetivo de evitar erros.

Para melhorar ainda mais a rede, as CNN usam camadas de pooling (camadas de agrupamento) que removem detalhes que não são necessários para a composição das imagens e então os dados de saída se tornam mais exatos.

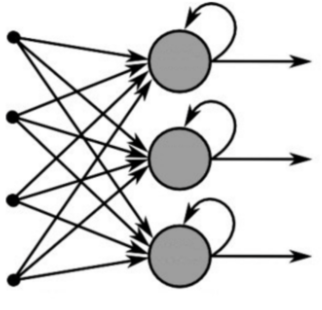

As redes RNN são mais usadas para dados sequenciais de uma série temporal, como dados de DNA. Além disso, esse tipo de arquitetura possui um mecanismo de retroalimentação, ou seja, é criado uma memória, o que se assemelha a um neurônio humano. A estrutura de uma RNN é composta por uma camada de entrada, camadas escondidas e uma camada de saída, essa rede guarda memórias, ou seja, os dados anteriores são levados em consideração pelo dado atual.

As RNN são usadas em várias áreas como finanças, epidemiologia e outras. Na biotecnologia, uma variação de RNN é usada, a chamada LSTM. Essa variação é usada em algumas ferramentas de bioinformática como no SignalP 5.0, uma ferramenta usada para prever peptídeo sinal em sequências de aminoácidos é o sequenciador Oxford Nanopore.

O LSTM então é uma RNN que surgiu com o objetivo de corrigir um problema recorrente nas RNN que é o vanishing gradient (gradiente de desaparecimento), problema que dificulta o treinamento das RNN pois os gradientes de função se aproximam de zero. Para corrigir o erro, a LSTM mantém o erro de forma constante, por várias camadas, dessa forma o modelo aprende com o erro. A sua arquitetura possui quatro redes neurais e diferentes blocos de memórias chamados de células, as quais contém a informação. Além disso, as LSTM possuem gates, em tradução livre “portões”, que realizam as manipulações de memória e existem 3 tipos de portões, os quais são: forget gate (portão esquecido), input gate (portão de entrada) e output gate (portão de saída).

No forget gate os dados são multiplicados por matrizes de peso e ganham novas informações, caso essas matrizes resultem em 1, as informações se mantém na célula, caso resultem em 0 essas informações são esquecidas. O input gate determina quais as informações devem entrar na célula, as novas informações passam por cálculos sigmóides, já que a equação da célula leva em consideração os dados existentes e aqueles que serão adicionados, dessa forma as informações não se perdem, e para ativar esses dados, uma função tanh é utilizada. E o output gate é o que leva as informações importantes para a próxima camada escondida da rede neural.

O uso do aprendizado profundo e suas várias estruturas de redes neurais auxiliam cada vez mais pessoas, em várias profissões. Continue acompanhando os próximos textos da série sobre Machine Learning para não perder nenhuma informação!

Isadora Guidotti

Biotecnologista, Mestre em ciências, CEO BIOSCIENT e doutoranda no Omixlab. Atua no desenvolvimento de uma ferramenta para design de novos peptídeos anticâncer usando deep learning.

Cite este artigo:

GUIDOTTI, I. Aprendizado Profundo: classificação de sequências. Revista Blog do Profissão Biotec. V. 10, 2023. Disponível em: <https://profissaobiotec.com.br/aprendizado-profundo-classificacao-sequencias/>. Acesso em: dd/mm/aaaa.

Referências:

ARMENTEROS, A.J.J., TSIRIGOS, K.D., SØNDERBY, C.K. et al. SignalP 5.0 improves signal peptide predictions using deep neural networks. Nat Biotechnol 37, 420–423, 2019.

Capítulo 10 – As 10 Principais Arquiteturas de Redes Neurais. Data Science Academy. Deep learning book. 2021. Disponível em: <https://www.deeplearningbook.com.br/as-10-principais-arquiteturas-de-redes-neurais/>. Acesso em: 23 Nov 2021.

Capítulo 40 – Introdução as Redes Neurais Convolucionais. Data Science Academy. Deep learning book. 2021. Disponível em: <https://www.deeplearningbook.com.br/introducao-as-redes-neurais-convolucionais/>. Acesso em: 23 Nov 2021.

KANG, E. Long short-term memory (LSTM): concept. Medium. 2017. Disponível em: <https://medium.com/@kangeugine/long-short-term-memory-lstm-concept-cb3283934359>. Acesso em: 06 Dez 2021.

KREMER, F.S. Criando um preditor de peptídeo sinal utilizando LSTM. Omixdata. 2020. Disponível em: <https://medium.com/omixdata/criando-um-preditor-de-pept%C3%ADdeo-sinal-utilizando-lstm-647db5b7ca07>. Acesso em: 06 Dez 2021.

LIU, Q., FANG, L., YU, G. et al. Detection of DNA base modifications by deep recurrent neural network on Oxford Nanopore sequencing data. Nat Commun 10, 2449, 2019.

MATSUMOTO, F., DUARTE, G. MURAKAMI, L. Redes neurais recorrentes. Medium. 2019. Disponível em: <https://medium.com/turing-talks/turing-talks-26-modelos-de-predi%C3%A7%C3%A3o-redes-neurais-recorrentes-439198e9ecf3>. Acesso em: 01 Dez 2021.

SOUZA, L.R. Representação, classificação e interpretação de sequências proteicas do vírus da dengue. Dissertação (mestrado) – Programa de Pós-Graduação em Informática, Universidade Federal do Amazonas. Manaus. 93f. 2021.

OSKOLKOV, N. LSTM to detect neanderthal DNA. Towards data science. 2019. Disponível em: <https://towardsdatascience.com/lstm-to-detect-neanderthal-dna-843df7e85743>. Acesso em: 06 Dez 2021.

WANG, C. The vanishing gradient problem. Towards data science. 2019. Disponível em: <https://towardsdatascience.com/the-vanishing-gradient-problem-69bf08b15484>. Acesso em: 06 Dez 2021.

YUANHANG, S; JAY KUO, C.C. On extended long short-term memory and dependent bidirectional recurrent neural network. Neurocomputing. v.356, p 151-161. 2019.

Fonte da imagem destacada: Vecteezy.